Популярные статьи

- Государственно-частное партнерство: теория и практика

- Международный форум по Партнерству Северного измерения в сфере культуры

- Мировой финансовый кризис и его влияние на Россию

- Совершенствование оценки эффективности инвестиций

- Качество и уровень жизни населения

- Фактор времени при оценке эффективности инвестиционных проектов

- Вопросы оценки видов социального эффекта при реализации инвестиционных проектов

- Государственная собственность в российской экономике - Масштаб и распределение по секторам

- Кластерный подход в стратегии инновационного развития зарубежных стран

- Перспективы социально-экономического развития России

- Теория экономических механизмов

- Особенности нового этапа инновационного развития России

- Экономический кризис в России: экспертный взгляд

- Налоговые риски

Популярные курсовые

- Учет нематериальных активов

- Потребительское кредитование

- Бухгалтерский учет - Курсовые работы

- Финансы, бухгалтерия, аудит - курсовые и дипломные работы

- Денежная система и денежный рынок

- Долгосрочное планирование на предприятии

- Диагностика кризисного состояния предприятия

- Интеграционные процессы в современном мире

- Доходы организации: их виды и классификация

- Кредитная система: место и роль в ней ЦБ и коммерческих банков

- Международные рынки капиталов

- Многофакторный анализ производительности труда

- Непрерывный трудовой стаж

- Виды и формы собственности и трансформация отношений собственности в России

- Анализ финансово-хозяйственной деятельности

Навигация по сайту

Исследовательские результаты и библиометрика: антагонистично ли противоречие? |

|

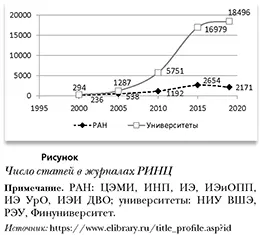

П.А. Минакир Проблема соизмерения затрат и результатов универсальна, и ее приходится решать на всех стадиях и для всех сегментов общественноэкономической системы. Наука не является, конечно, исключением. Однако нельзя не учитывать специфику постановки и решения этой задачи в каждом конкретном случае и для каждой конкретной сферы деятельности. В случае науки мы сталкиваемся (по крайней мере в российском варианте) с очевидной неоднородностью во времени этой специфики. И дело не в изменении роли науки как таковой, а в ее статусе как общественного института. До 1992 г. в России наука имела статус обязательного института общественного развития, полезностью продукта которого являлся масштаб и достоверность знаний о природе и обществе, что, во-первых, гарантировало уменьшение энтропии и наличие на каждом этапе развития достаточного запаса способов и вариантов решения самых разных проблем, а во-вторых, обеспечивало сырьем технологический и технический прогресс, т.е. повышение продуктивности использования общественных ресурсов и поддержание уровня необходимого разнообразия общественно-экономической системы. Это обусловливало интервальный принцип финансирования. Нижнее ограничение определялось оценкой минимально необходимого с точки зрения общественной полезности уровня разнообразия научных направлений и организаций, а также минимально допустимого размера последних при принятых нормативах внутренних затрат с учетом особенностей их структуры в зависимости от научного профиля. Верхнее ограничение определялось абсолютными размерами общественных ресурсов при данной оценке общественной полезности научно-технического сегмента общественно-экономической системы. Оценка организаций, школ и отдельных исследователей осуществлялась главным образом с позиций их научного вклада в копилку знаний, технологий, технических достижений, гуманитарно-социальных идей и представлений. Непосредственная оценка в форме прямого влияния научно-технической деятельности на результаты общественного развития в форме открытий, изобретений, разработки новых технологий и технических образцов, продуктов, материалов, процессов и т.п. была не всегда возможна, но государство настаивало на такой оценке, для чего и был придуман показатель «практической значимости», не имевший строгого количественного выражения, но стимулировавший постоянный поиск реального и/или виртуального взаимодействия демонстрируемых научных результатов с общественно-экономической реальностью. Публикации также являлись, конечно, элементом системы оценки результативности, но преимущественно (если не исключительно) играли роль инструмента внутриклубного сравнения научных организаций и отдельных ученых. Это было связано не только с тем, что количество научных журналов было очень невелико, но главным образом с тем, что, во-первых, публикации (журнальные статьи и монографии), как правило, следовали за научными результатами и служили способом их представления для научного обсуждения и экспертизы, а во-вторых, само по себе количество публикаций не входило в перечень государственных показателей эффективности использования средств на развитие научных организаций. Полезность (реальная или виртуальная) не была привязана к публикационной активности. В 1990-х годах наука по существу была предоставлена самой себе. Статус общественного института был практически утерян и заменен статусом «чемодана без ручки» — без науки вообще оставаться не совсем прилично, но что с ней делать, непонятно, а главное ее общественная полезность была фактически обнулена. Соответственно, и проблема измерения этой полезности, установления ее связи с выделением ресурсов для функционирования и развития не рассматривалась. Наличие или отсутствие публикаций, как и собственно результатов исследований, оставляла и общество, и институты власти/управления безучастными. Ситуация стала меняться в начале 2000-х годов, когда началась, в частности, дискуссия, инициированная в том числе и государственными инстанциями, о необходимости и содержании реформы РАН. В ходе этой дискуссии российской науке, особенно сектору общественных наук, в качестве одной из самых серьезных (вероятно, потому что наиболее просто формулируемой) претензий была предъявлена «невидимость» в мировом потоке научных публикаций. Попытка реактивного ответа, без какого-либо глубокого разбирательства в причинах структурных, финансовых и институциональных провалов, привела к инициированию ориентации на количественные показатели публикационной активности в рамках Академии наук. Эта инициация была закреплена в качестве критерия оценки результативности научных организаций РАН в рамках пилотного проекта по реформированию РАН, который стартовал в 2006 г. Фактически с 2015 г. заступившему на место РАН в качестве регулятора системы фундаментальных исследований в РФ Федеральному агентству научных организаций (ФАНО РФ) оставалось только узаконить эту инициативу и довести ее практически до абсурда, что очень легко выполняется абсолютизацией наиболее простых и понятных финансовому регулятору показателей. В результате к настоящему времени публикационная «активность» превратилась в основной критерий эффективности как отдельных ученых, так и научных и образовательных организаций. Это, естественно, вызвало взрывной рост числа публикаций. В период 2000-2019 гг. (полных данных за 2020 г. пока нет) общее число публикаций, размещенных в Российской электронной библиотеке, увеличилось на порядки. Только для ведущих экономических институтов РАН и трех ведущих российских экономических университетов рост составил 34 раза, а число журнальных статей, опубликованных ими же в этот период, увеличилось в 39 раз (см. рисунок). Именно с 2005 г. начался столь бурный рост. Особенно преуспели университеты, увеличившие общее число публикаций за 2005-2019 гг. в 13,3 раза, а число журнальных статей — в 14,4 раза против, соответственно, 3,5 и 4,1 раз у академических институтов.

Университеты добились впечатляющего роста числа публикаций в основном за счет экстенсивного фактора — увеличения числа авторов в 2,15 раза за 2011-2019 гг. при росте количества статей в этот период в 2 раза. Отчасти это было связано, вероятно, с использованием значительно более широких, чем у академических институто в, финансовых возможностей для стимулирования ранее инертных в смысле научных публикаций преподавательских кадров, а отчасти и с перемещением в той или иной форме ученых из РАН в университеты, опираясь на все те же расширенные финансовые возможности, происхождение которых от части связано с навязчивой идеей «научных администраторов» сконцентрировать исследовательскую деятельность в вузах. Последнее, конечно, нельзя достоверно утверждать без привлечения большого массива эмпирических данных, часть из которых скорее всего совершенно недоступна по коммерческим соображениям, но это предположение вполне правдоподобно. Институтам РАН в условиях не просто скудного, а критически дефицитного финансирования пришлось форсировать интенсификацию труда своих авторов, количество которых выросло в 2011—2019 гг. на 17% при увеличении числа опубликованных статей на 33%1. Различие степени интенсификации публикационной нагрузки хорошо иллюстрируется показателем подушевой публикационной результативности авторов в университетах и институтах РАН в соответствии с приведенным списком анализируемых организаций (табл. 1). Таблица 1 Число опубликованных в РИНЦ журнальных статей в расчете на 1 автора

Достоверное определение наличия или отсутствия такой зависимости, а тем более ее количественная оценка, требуют проведения специального и трудоемкого исследования с привлечением большого числа экспертов. Попробуем воспользоваться косвенными способами ответа на этот вопрос. Достаточно правдоподобным предположением является то, что рост числа цитирований конкретной публикации свидетельствует о высоком (растущем) интересе научного сообщества к изложенным в этой публикации результатам. В этом случае существенный рост числа цитирований действительно должен отражать прогресс в области генерирования научных результатов. Конечно, следует вводить поправки на конкретную предметную область, исследуемую в опубликованных работах. Но даже если отвлечься от этого, что будет, конечно, чрезмерно сильным допущением, то, судя по динамике цитирования журнальных статей, публикуемых сотрудниками анализируемых организаций, какого-либо не только существенного, но даже заметного прорыва в области качества публикуемых, а следовательно, и получаемых исследователями результатов не произошло (табл. 2). Таблица 2 Цитирование публикаций в РИНЦ (в среднем за год, без самоцитирований)

Источник: рассчитано по данным https://www.elibrary.ru/title_profile.asp?id Среднее за год число цитирований для 2011-2015 и 2016-2020 гг. для институтов РАН варьирует в пределах 9-10 цитирований, а для университетов — 3-5 цитирований. При всех изъянах показателя цитирований как свидетельства качества статей все-таки всплески цитирований отображают концентрацию интереса исследователей, отслеживающих данное направление науки, на тех или иных публикациях, сигнализируя о наличии в них новых результатов, генерирующих новые идеи, интерпретации, концепции. Конечно, усредненные показатели цитирований могут маскировать, и наверняка маскируют, выбросы цитирований по отдельным публикациям. Но это лишь подтверждает, что степень такой маскировки практически никак не изменилась после перехода к тотальному стимулирования публикационного вала. Еще одним косвенным свидетельством того, что рост числа публикаций имеет мало общего с прогрессом собственно научных исследований, является статистика изменений среднего значения импакт-фактора журналов, в которых публикуются статьи (табл. 3). По мере роста числа статей, как правило, среднее значение для организаций снижается, за исключением Института народнохозяйственного прогнозирования и Высшей школы экономики, для которых этот показатель формируется на основе импакт-фактора (факторов) опорного журнала (журналов) самих этих организаций. Таблица 3 Среднее значение импакт-фактора журналов, в которых опубликованы статьи, 2011-2020 гг.

Следовательно, в основном число статей, размещаемых в высокорейтинговых журналах, или не растет, или растет медленнее числа публикаций в журналах сравнительно непритязательных. Если согласиться с тем, что лучшие результаты публикуются именно в высокорейтинговых научных журналах, вывод очевиден — основной прирост количества публикаций приходится (с учетом вышеприведенных исключений) на статьи, не имеющие особой научной ценности и, соответственно, не привлекающие интереса высокорейтинговых журналов. Конечно, существует самостоятельная проблема идентификации тех журналов, в которых публикуются наиболее привлекающие внимание научной общественности исследовательские результаты. Формальный рейтинг РИНЦ, который регулярно присваивается журналам и формирует их иерархию, основываясь на методике, синтезирующей показатели цитируемости, импакт-фактор, распределение цитирований по журналам (индекс Херфиндаля) и пр., не является безусловной лоцией при определении отношения научного сообщества к тем или иным журналам. Огромное значение имеют тематические пристрастия и распределение научного сообщества по этим пристрастиям. Правда, вычисление рейтинга РИНЦ обязательно учитывает тематическую направленность того или иного журнала, но в предельно агрегированном виде. Например, все журналы по экономической тематике попадают в единую тематическую рубрику «Социальные науки». Поэтому даже экспертные оценки качества журналов в рамках такого гиперагрегированного множества (например, в ходе общественной экспертизы) чрезмерно чувствительны к количественным разделениям экспертов по тематическим клубам. В качестве примера можно привести проведенный автором блиц-опрос примерно полусотни экспертов, специализирующихся в области общей экономики и пространственной экономики. Экспертам было предложено дать собственную версию рейтинга для почти 60 экономических журналов, имеющих наивысшие оценки РИНЦ. К подобным сопоставлением следует относиться осторожно, но в ряде публикаций ранее тоже отмечались регулярные смещения оценок рейтингов научных журналов при переходе от библиометри-ческих к экспертным оценкам (Рубинштейн, 2016). Сравнение отобранных этими экспертами 15 лучших, с их точки зрения, журналов при сравнении с 15 лучшими журналами, по версии РИНЦ (список 1), показало совпадение на уровне 53%. Почти наверняка расширение круга экспертов привело бы к изменению в ту или иную сторону этого показателя. Одним из следствий такого сравнения является вероятность того, что искусственное ограничение круга высокорейтинговых журналов (например, только журналами, входящими в ядро или в Web of Sience/Scopus) обязательно искажает оценку реальной результативности научной деятельности, подменяя ее в значительной степени публикационной активностью (табл. 4). Таблица 4 Список 1. Первые 15 экономических журналов

Эксперты и РИНЦ также разошлись в оценке степени тождественности научного уровня журналов и факта их пребывания в базах Web of Science/Scopus. По версии РИНЦ, в списке первых 15 экономических журналов находятся 3 журнала, не входящие в эти базы, а по версии экспертов, таких журналов 4, но их состав (за исключением «Пространственной экономики») выглядит иначе. Такие институциональные смещения также обычны (Минакир, 2019). В целом погоня за количеством публикаций не привела к качественному скачку в самих исследованиях. Впечатляющий рост массы публикаций констатируется при, в лучшем случае, стагнации собственно научных результатов. Если научные результаты отождествить с «полезным продуктом» науки, а нарастающую массу публикаций — с затратами времени на их подготовку, то следует признать, что существующая система оценивания результативности в науке стимулирует рост затрат, при том что полезность научного продукта в лучшем случае не поспевает за затратами. Вместе с тем, как свидетельствуют данные, приведенные на рисунке, количественный рост числа публикаций также уже вышел на плато, что свидетельствует, во-первых, о вероятном исчерпании возможностей при существующих финансово-материальных и кадровых условиях наращивать количество публикуемых версий наличной массы результатов, а во-вторых, о достижении предела в степени интенсификации публикационной деятельности научных сотрудников и преподавателей вузов, не генерирующих научные результаты, но тиражирующих ранее полученные. Конечно, полная переориентация оценки эффективности научной деятельности с публикационной активности на любые способы оценки качества и количества исследовательских результатов практически невозможна. Это означало бы ликвидацию прочно укоренившегося в российской практике института приоритетности вертикальной иерархии над горизонтальными взаимодействиями (Олейник, 2019, с. 18; Ореховский, 2019). Однако восстановление института научной экспертизы результатов исследований настоятельно необходимо. При этом оценка публикационной активности может играть тоже важную роль как инструмент сравнения продуктивности научных сотрудников. Принципиально при этом сравнивать между собой сотрудников, генерирующих идеи, и тех, кто тиражирует и интерпретирует полученные не ими результаты. Впрочем, и для сравнения между собой результативности научных организаций библиометрические показатели вполне могут использоваться, но лишь при условии, что сравниваются продуцирующие более или менее одинаково оцениваемые экспертами научные результаты, ориентированные на относительно однородную пользовательскую среду. Еще одно принципиально важное условие в пользу полезности библиометрических показателей — оцениваемые научные результаты как организаций, так и отдельных сотрудников должны быть опубликованы. В общем случае уровень научного результата вполне может отождествляться с научным статусом журнала, в котором размещена эта публикация.

1 Здесь и далее расчеты выполнены по данным профилей соответствующих организаций в e-library. 2 Составлено по данным ttps://www.elibrary.ru/titles_compare.asp?rubriccode=060000&ratingyear=2019&sortorder=0&o rder=0&titleid=10623&pagenum=1 ЛИТЕРАТУРА / REFERENCESМинакир П.А. (2019). Экономические журналы в интерьере конкурентного рынка // Журнал Новой экономической ассоциации. № 4 (44). С. 210-216. [Minakir P.A. (2019). Economic magazines in the interior of a competitive market. Journal of the New Economic Association, 4 (44), 210-216 (in Russian).] Олейник А. (2019). Научные трансакции: сети и иерархии в общественных науках. М.: ИНФРА-М. [Oleinik A. (2019). Scientific transactions: Networks and hierarchies in the social sciences. Moscow: INFRA-M (in Russian).] Ореховский П.А. (2019). «Научные трансакции» и слепые пятна в анализе институтов общественных наук (О книге профессора А.Н. Олейника «Научные трансакции: сети и иерархии в общественных науках») // Вопросы теоретической экономики. № 2. С. 174-180. [Orekhovskii P.A. (2019). “Scientific transactions” and blind spots in the analysis of institutions of social sciences (About the book of Professor A.N. Oleinik “Scientific transactions: Networks and hierarchies in the social sciences”). Voprosy Teoreticheskoy Ekonomiki, 2, 174-180 (in Russian).] Рубинштей А.Я. (2016). Ранжирование экономических журналов: научный метод или «игра в цыфирь»? // Журнал Новой экономической ассоциации. № 2 (30). С. 162175. [Rubinstein A.Y. (2016). Ranking of Russian economic journals: The scientific method or “numbers game”? Journal of the New Economic Association, 2 (30), 162-175 (in Russian).]

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Популярные книги и учебники

- Экономикс - Макконнелл К.Р., Брю С.Л. - Учебник

- Бухгалтерский учет - Кондраков Н.П. - Учебник

- Капитал - Карл Маркс

- Курс микроэкономики - Нуреев Р. М. - Учебник

- Макроэкономика - Агапова Т.А. - Учебник

- Экономика предприятия - Горфинкель В.Я. - Учебник

- Финансовый менеджмент: теория и практика - Ковалев В.В. - Учебник

- Комплексный экономический анализ хозяйственной деятельности - Алексеева А.И. - Учебник

- Теория анализа хозяйственной деятельности - Савицкая Г.В. - Учебник

- Деньги, кредит, банки - Лаврушин О.И. - Экспресс-курс

Новые книги и журналы

Популярные лекции

- Шпаргалки по бухгалтерскому учету

- Шпаргалки по экономике предприятия

- Аудиолекции по экономике

- Шпаргалки по финансовому менеджменту

- Шпаргалки по мировой экономике

- Шпаргалки по аудиту

- Микроэкономика - Лекции - Тигова Т. Н.

- Шпаргалки: Финансы. Деньги. Кредит

- Шпаргалки по финансам

- Шпаргалки по анализу финансовой отчетности

- Шпаргалки по финансам и кредиту

- Шпаргалки по ценообразованию

- 50 лекций по микроэкономике - Тарасевич Л.С. - Учебное пособие

Популярные рефераты

- Коллективизация в СССР: причины, методы проведения, итоги

- Макроэкономическая политика: основные модели

- Краткосрочная финансовая политика предприятия

- Марксизм как научная теория. Условия возникновения марксизма. К. Маркс о судьбах капитализма

- История развития кредитной системы в России

- Коммерческие банки и их функции

- Лизинг

- Малые предприятия

- Классификация счетов по экономическому содержанию

- Кризис отечественной экономики

- История развития банковской системы в России

- Маржинализм и теория предельной полезности

- Кризис финансовой системы стран Азии и его влияние на Россию

- Иностранные инвестиции

- Безработица в России

- Источники формирования оборотных средств в условиях рынка